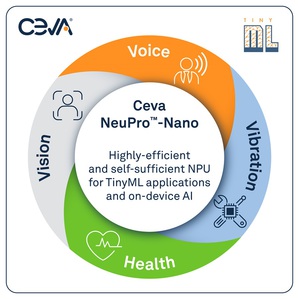

全球晶片和軟體IP授權廠商Ceva公司推出Ceva-NeuPro-Nano NPU,擴展其Ceva-NeuPro Edge AI NPU產品系列。這些高效NPU可為半導體企業和OEM廠商提供所需的功耗、性能和成本效益以便在用於消費、工業和通用AIoT產品的SoC中整合TinyML模型。

|

| 用於Ceva-NeuPro NPU系列的Ceva-NeuPro Studio完善AI SDK,支援包括TensorFlow Lite for Microcontrollers和microTVM的開放式AI框架,可加快開發 TinyML應用。 |

根據研究機構ABI Research預測,至2030年, TinyML出貨量超過40%將採用專用TinyML硬體,而非由通用MCU驅動。Ceva-NeuPro-Nano NPU解決了TinyML所面臨的特定性能難題,加以實現AI,廣泛應用於消費和工業物聯網應用中的語音、視覺、預測性維護和健康感知等領域。

新型 Ceva-NeuPro-Nano嵌入式AI NPU架構完全可程式設計,可高效執行神經網路、特徵提取、控制程式碼和DSP程式碼,並支援先進的機器學習資料類型和運算子,包括原生變換器運算、稀疏性加速和快速量化。與需要結合CPU或DSP並且基於AI加速器架構的現有TinyML工作負載處理器解決方案相比,自給自足架構使得Ceva-NeuPro-Nano NPU具有高效能、更小的矽片尺寸及更優異的性能。此外,Ceva-NetSqueeze AI壓縮技術可直接處理壓縮模型權重,減少80%的Ceva-NeuPro-Nano NPU記憶體占用,從而解決阻礙AIoT處理器廣泛應用的關鍵瓶頸問題。

Ceva-NeuPro-Nano NPU提供兩款配置,包括配備32個int8 MAC的Ceva-NPN32和配備64個int8 MAC的Ceva-NPN64,皆借助Ceva-NetSqueeze獲得直接處理壓縮模型權重功能。Ceva現在已提供Ceva-NeuPro-Nano NPU授權許可。