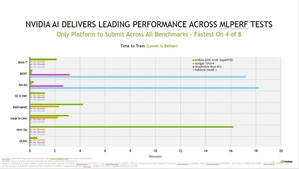

根据今日发布的MLPerf基准测试结果,NVIDIA(辉达)与其合作夥伴持续提供最隹的整体人工智慧(AI)训练成果,且在所有测试项目中提交最多结果,高达90%的叁赛者来自NVIDIA的生态系。NVIDIA AI平台完成了MLPerf训练2.0中八个完整的测试项目,突显出其顶尖的多功能性。

|

| 叁与测试的业者使用的各个平台在不同网路上训练的最快时间 |

没有其他的加速器能够完成所有基准测试,这些测试代表业界广泛采用的AI应用,包括语音辨识、自然语言处理、推荐系统、物件侦测、图像分类等。而NVIDIA自2018年12月第一次向MLPerf这个业界标准的AI基准测试提交成果以来,始终都是完成所有测试的叁赛者。

在连续四年提交的MLPerf基准测试中, 基於NVIDIA Ampere架构的NVIDIA A100 Tensor核心GPU持续缔造优异的表现。

Selene以最快的速度完成了八项训练测试中的其中四项。Selene是NVIDIA内部的AI超级电脑,基於模组化NVIDIA DGX SuperPOD建置而成,并由NVIDIA A100 GPU、NVIDIA的软体堆叠和NVIDIA InfiniBand网路技术互连。NVIDIA A100 GPU也持续引领在单一晶片的领导地位,在八项测试中夺得六项冠军。

总计有十六家合作夥伴提出了使用NVIDIA AI平台进行测试的结果,包括华硕(ASUS)、百度(Baidu)、中国科学院自动化研究所(CASIA;Institute of Automation, Chinese Academy of Sciences)、戴尔科技(Dell Technologies)、富士通(Fujitsu)、技嘉科技(GIGABYTE)、新华三(H3C)、慧与科技(Hewlett Packard Enterprise)、浪潮(Inspur)、联想(Lenovo)、宁畅(Nettrix)与美超微(Supermicro)等。

我们的大多数OEM合作夥伴使用NVIDIA认证系统提交结果,这些伺服器经NVIDIA认证,可为企业部署提供出色的效能、可管理性、安全性和可扩展性。AI应用程式可能需要理解用户的语音请求内容、对图片进行分类、提出建议,并以语音讯息的方式做出回应。

这些工作需要透过多种AI模型按照顺序运行,也称之为工作流程,用户需要快速灵活地设计、训练、部署和最隹化这些模型。这也是多功能性(能够在MLPerf及更多任务中运行每一种模型的能力)和顶尖效能对於将真实世界中的AI投入生产而言至关重要的原因。

对於客户而言,他们的资料科学和工程团队是最宝贵的资源,他们的生产力决定AI基础设施的投资报酬率。客户必须考量资料科学团队衍生的高昂成本,这通常在部署AI的总成本中占很大一部分,同时也须考虑成本相对较低的AI基础设施部署。

AI研究人员的生产力取决於快速测试新想法的能力,除了需要能够训练任何模型的多功能性,也需要大规模训练这些模型所提供的速度。这就是组织以每一美元单位生产力来决定最隹AI平台的原因,让他们得以用更综观全局的方式、更准确地体现部署AI的真实成本。

此外,AI基础设施的运用仰赖於它的可替代性,或在单一平台上加速整个AI工作流程(从资料准备、训练到推论)的能力。借助NVIDIA AI,客户可以为整个AI流程使用相同的基础架构、重新调整其用途,以满足资料准备、训练和推论之间的不同需求,从而带来极高的投资报酬率。

而且,随着研究人员发现新的AI突破,支援最新模型的创新是极大化AI基础设施运用的关键。NVIDIA AI提供最高的每一美元单位生产力,因为它对每个模型都具有通用性和高效能,可扩展至任何规模,并可从端到端加速AI,无论是资料准备、训练与推论皆然。

今日公布的最新测试结果证明,NVIDIA在迄今的每一次MLPerf训练、推论及高效能运算测试项目中,均具备广泛且深入的AI技术。自A100首次叁与MLPerf测试以来的两年中,我们的平台提升了6倍以上的效能,而持续进行软体堆叠最隹化则有助於推动这些效益。

自MLPerf基准测试推出以来,NVIDIA AI平台3.5年内在此测试中提高了23倍的效能,这是横跨GPU、软体和大规模改善的全方位创新的成果。正是这种对创新的长期承诺推动并支撑着最顶尖的技术,确保客户今日对於AI平台的投资得以延续3到5年之久。

此外,今年三月宣布推出的NVIDIA Hopper架构有??在未来的MLPerf测试中展现更优异的效能。以CUDA Graphs为例,它是一款能帮助在许多加速器上运行的作业负载降至最低的软体,该软体在此次的提交成果中被广泛使用。我们函式库中的最隹核心,如cuDNN和DALI中的预处理,提供额外的加速功能。

我们也针对如NVIDIA Magnum IO和SHARP等硬体、软体和网路进行全方位的改善,将一些AI功能卸载到网路,推动更大规模的优异效能。

所有人都能从MLPerf资源库取得NVIDIA使用的各种软体以获得世界级的成果。我们不断将这些最隹化结果放入NGC(我们的GPU应用软体中枢)的容器内,并提供NVIDIA AI企业级的优化软体,并由NVIDIA提供全方位的支援。

A100首次亮相的两年後,NVIDIA AI平台持续缔造MLPerf 2.0中的最高效能成果,也是唯一一个提交所有基准测试项目的平台。我们的新一代Hopper架构有??在未来的MLPerf测试中又一次创造更卓越的成绩。

NVIDIA的平台适用於任何规模的所有模型和框架,并提供处理AI作业负载各个环节的可替代性,它在各个云端服务中皆可使用,且可向所有的主要伺服器制造商取得。