美光科技宣布推出業界首款第二代 8 層堆疊(8-High)24GB HBM3,並開始送樣。此產品頻寬達 1.2TB/s 以上,每腳位傳輸速率超過 9.2Gb/s,較目前市面上的HBM3解決方案高出 50%。此外,美光第二代HBM3的每瓦效能較前幾代產品提升2.5 倍,刷新 AI 數據中心的關鍵性能、容量及功耗指標。這些改進縮短了業界訓練 GPT-4 等大型語言模型及其更高階版本所需時間。

|

| /news/2023/07/30/0929567130S.jpg |

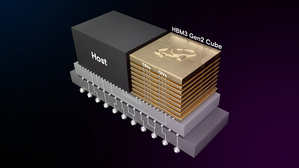

奠基於1β DRAM 製程節點,美光的 HBM 解決方案能在業界標準封裝尺寸中,將24GB的晶粒組裝為8層高度的立方體。美光 12 層堆疊(12-High)36GB HBM3 亦將於 2024 年第一季開始送樣。

透過此堆疊高度,美光可提供較競品解決方案高出 50% 的容量。美光第二代 HBM3 性能功耗比和每腳位傳輸速率的改善,對因應當前 AI 資料中心的高功耗需求而言至關重要。美光提供較現行 HBM3 解決方案多出一倍的直通矽晶穿孔(TSV)數量,又以五倍金屬密度減少熱阻抗,並採用高能效資料路徑設計,實現功耗的改善。

在生成式AI方面,美光第二代 HBM3 亦能符合多模態數兆參數AI模型所需。每組堆疊24GB的容量、大於9.2Gbps的每腳位傳輸速率除了能減少大型語言模型 30% 以上的訓練時間,進而降低總體擁有成本外,也能大幅提升每日查詢次數,讓訓練完成的模型在使用時更有效率。

美光副總裁暨運算產品事業群總經理 Praveen Vaidyanathan表示:「美光第二代 HBM3 的研發重點,在於為客戶及業界提供卓越的 AI 及高效能運算解決方案。我們所考慮的一項重要標準,就是第二代 HBM3 產品能否輕鬆與客戶平臺整合。對此,記憶體內建的自我測試(MBIST)不僅可徹底程式化,還能以規格中的最高每腳位傳輸速率進行測試,有助於改善與客戶的測試能力,提升協作效率,並縮短上市時間。」