在AI当道的今日,GPU加速运算已经来到关键点,世界正在加入这个快速运算的行列。不止相关开发者在五年内成长了10倍,CUDA下载量也在五年内跃升5倍。而全球前50大超级电脑中的GPU FLOPS(浮点运算)在五年内成长15倍,比摩尔定律更快,这意味着GPU运算时代已经来临。

|

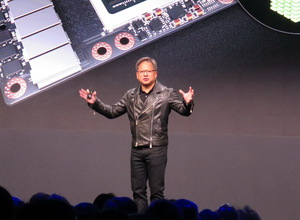

| NVIDIA执行长黄仁勋指出,台湾是PC及云端运算的中心,而现在台湾正要进行AI运算革命。 |

NVIDIA执行长黄仁勋指出,在未来十年,每年的运算需求将成长100倍。在今年,资料中心消耗约2000万个CPU,若以每个处理器0.5TF来算,将共会有1000万TF。随着摩尔定律减缓,10年内成长百倍的1000万TF,将会以替代方式运作。而NVIDIA的CUDA GPU运算是延展摩尔定律最主要的方法。到2028年,全球的需求将达到相当於1000万NVIDIA Volta的GPU数量。

在今年的GTC 2018台北大会上,黄仁勋强调,将持续精进强化GPU运算能力;而庞大的系统、基础架构,以及软体生态系统正为绕着NVIDIA的平台而建立。这些庞大的终端市场商机,都将与我们的软体平台共同合作运作。

黄仁勋说,超级电脑是现代科学的重要工具。在过去10年来,我们开发了一整套用於超级运算的函式库、系统管理和编程工具。针对分子建模、量子化学和力学、天气预报、气候研究、能源探索、物理模拟、资料科学以及人工智慧等,超过550种高效能运算应用了CUDA加速。未来,每台超级电脑也都必须在务实的成本与能耗的考量基础上,加速实现百万亿次级和百亿级性能。

GPU运算是AI发展的加速引擎。根据一家AI研究机构OpenAI最近公布的一份研究报告显示,培训AI模型的运算将在五年内成长30万倍。这比摩尔定律还要快上3万倍。透过增加数据和GPU效能,机器可以编写非常复杂的软体,不需要人工编写,并可解决近期无法解决的问题。

而未来的运算也将融合模拟和机器学习方法。电脑可以透过学习数据中的重要特徵,模拟物理定律或预测结果。NVIDIA再造GPU,创造Tensor Core GPU,这是融合了HPC与AI运算的新架构。Tensor Core GPU具有多种精度,支持高运算量FP64、FP32、FP16、Int8和单周期4x4矩阵乘法累加来进行深度学习。

Volta是第一款Tensor Core GPU,并采用125张Tensor TFLOPS来增强AI,比起以往的GPU快上10倍。

黄仁勋说,这个世界比起以往,更需要大型的GPU运算效能。研究人员和开发者需要巨大的GPU来开发更强大的模型,目前GPU已经处於制造的极限。我们发明了一种突破性开关,可以将多个GPU连接并编程为单个GPU。NVSwitch是一种新型高频宽交换器,其协议可扩展跨16个Volta Tensor核心GPU的单晶片内建记忆体。程式设计师可看到具有2 PFLOPS性能的单一512GB GPU。

GPU运算是加速整体的堆叠:GPU、系统设计和软体、演算法和应用程式。DGX-2的加速套件比DGX-1的性能提高了10倍。

一台DGX-2的效能可媲美300台双CPU的伺服器,却只要1/8的价格与1/18的功率。

台湾正全面拥抱AI以强化社会、增加生产力及全球竞争力。制造方面,富士康正在使用AI大幅超越人类的检测效率。医疗方面,中国医药大学附设医院已使用AI协助医师做出更快、更精准的癌症肿瘤转移预测。台湾大学则用AI来更快速区别鼻咽癌危急器官。公共安全方面,台湾人工智慧实验室用AI来协助台南市政府监测桥梁结构,预防台风损害。交通方面,桃园市政府预计在2020年前,让30%行驶固定路线的公车,配备L3自动驾驶功能。

黄仁勋认为,台湾是PC及云端运算的中心,而现在台湾正要进行AI运算革命。全球最重要的伺服器制造商在每个城市都采纳了GPU加速伺服器。包括广达、云达、富士康、英业达、纬创、纬颖、华硕、技嘉、华擎、泰安、宏??等,在过去十年,总和他们的伺服器出货量达1亿台,占全球伺服器90%。这些都是让NVIDIA持续成长的动力。全球最大的IT公司也采用NVIDIA平台,包括IBM、DELL、HPE及Supermicro等,他们都预见了这波由GPU运算所带起的AI商机。